读完须要

6分钟

速读仅需 2分钟

你有没有碰着过这样的问题,网页里面有几百个网址链接,须要你统计下来,你会逐一粘贴复制到表格里吗?

或者要统计公司潜在客户的邮箱,须要通过关键词去搜索,然后每个网页都要点击进去,找找看有没有邮箱呢?

对付上面这张种大批量重复的事情,难道就没有更好的、快捷的、大略的办理方案吗?

当然是有的,本日这篇文章将给你分享 ——如何利用大略爬虫办理重复大量的事情。

不过,在进入教程之前,我们要聊聊:

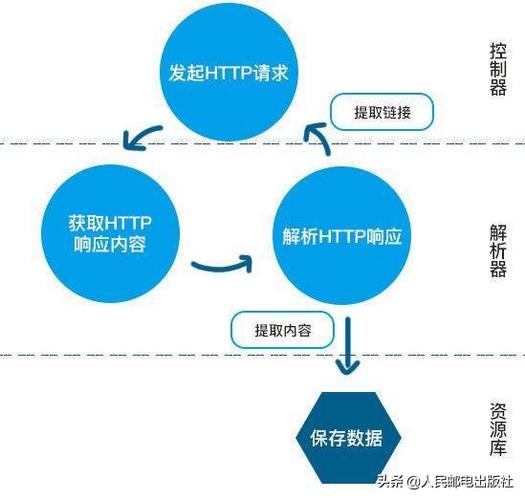

什么是爬虫

大略来说,爬虫便是一种网络机器人,紧张浸染便是搜集网络数据,我们熟知的谷歌和百度等搜索引擎便是通过爬虫搜集网站的数据,根据这些数据对网站进行排序。

既然谷歌可以利用爬虫搜集网站数据,那我们是否能利用爬虫帮我们搜集数据呢?

当然是可以的。

我们可以用爬虫做什么

前面已经讲过,如果你碰着一些重复大量的事情,实在都可以交给爬虫来做,比如:

•搜集特定关键词下的用户邮箱•批量搜集关键词•批量下载图片•批量导出导入文章•……

比如我想搜索iphone case的干系用户邮箱,那么可以去Google搜索iphone case这个关键词,然后统计下干系网页,把网址提交给爬虫程序,接着我们就等着出结果就行了。

当然,创作一个特定的爬虫程序须要一定的技能根本,市情上主流都是利用python来制作爬虫程序,不过我们本日用一个更大略易懂的爬虫软件——Google Sheet,不用写任何代码的哦!

利用Google Sheet爬取数据

Google sheet(以下简称GS)是Google旗下的在线办公套件之一,和微软的办公三剑客恰好逐一对应:

•Google doc - Word•Google sheet - Excel•Google presentation - PPT

基本上Excel上的公式都可以在GS上运行,不过GS还要其余一个公式,是Excel不具备的,也便是

IMPORTXML

我们新建一个GS,这个操作和Execl操作同等,然后在A1栏输入我们须要爬取数据的网址,记得网址必须包含https或http,只有这种完全写法才会生效。

然后在B1栏输入

=importxml(A1,''//title\公众)

在B1栏输入完成之后我们就会得到如下数据

这样就得到了网址的SEO Title。

SEO Title涌如今每个浏览器窗口的标签处,也是网站呈现给Google搜索引擎的第一上岸点,里面包含该网页的关键词等主要信息。

接下来我们在C1栏输入如下公式:

=IMPORTXML(A1,\"大众//meta[@name='description']/@content\公众)

然后我们就得到了网页的Meta Description

我们能看到,刚才搜集的两个信息便是Google SERPs中很主要的两个元素,Title和Description,基本上要做好站内SEO,这两点要做好。

批量爬取网页SEO信息

按照上面的两个公式,我们分别在A1B1C1栏中输入网址、Title、Description,然后A列填满想要爬取的网址,B列和C列利用Excel的复制下拉选项,便是鼠标放到C1栏的右下角涌现十字标识后,往下拉动鼠标,C列的其他栏会自动添补好C1的公式:

然后我们就得到了所有网址的Title和Description

统计完这些数据之后,我们之后就再也不用愁怎么写SEO Title啦。

如果大家想爬取全体网址的Title与Description,可以把竞品的网址全部放上来。至于如何获取全体网址的链接,大家可以去查一下网址的sitemap.xml,在这里面可以找到一个网站所有的链接。

理解公式构造

既然importxml可以批量爬取SEO Title,那么当然也是可以爬取其他内容的,比如邮箱地址与链接地址,我们先来剖析一下公式构造:

=IMPORTXML(A1,\公众default\公众)

A1表示所在列,default表示须要爬取的页面内容构造,以是我们只要修正default值,就能够爬取更多信息,这里给大家展示一下我们在做SEO和统计信息中常用的值

站内链接,个中的domain.com换成要统计的域名

//a[contains(@href, 'domain.com')]/@href

站外链接,个中的domain.com换成要统计的域名

//a[not(contains(@href, 'domain.com'))]/@href

邮箱统计:

//a[contains(@href, 'mailTo:') or contains(@href, 'mailto:')]/@href

社交链接,包括linkedin, fb, twitter

//a[contains(@href, 'linkedin.com/in') or contains(@href, 'twitter.com/') or contains(@href, 'facebook.com/')]/@href

如果你想理解更多能利用的爬虫公式,可以参考Google 官方文档

https://support.google.com/docs/answer/3093342?hl=zh-Hans

也可以深入理解一下xpath

https://www.w3schools.com/xml/xpath_intro.asp

(来源:外贸增长官)

以上内容属作者个人不雅观点,不代表雨果网态度!

本文经原作者授权转载,转载需经原作者授权赞许。

上雨果网搜索“跨境资料库”,领取欧美/东南亚各国市场商机、各大平台热销品报告、跨境电商营销白皮书!