随着互联网的飞速发展,大数据时代已经来临。在这个时代,如何高效处理和分析海量数据成为企业关注的焦点。Hadoop作为一款开源的大数据处理框架,因其强大的数据处理能力、高可靠性、可伸缩性等优点,被广泛应用于各个行业。本文将为您介绍如何在本地搭建Hadoop集群,助力您轻松应对大数据挑战。

一、Hadoop简介

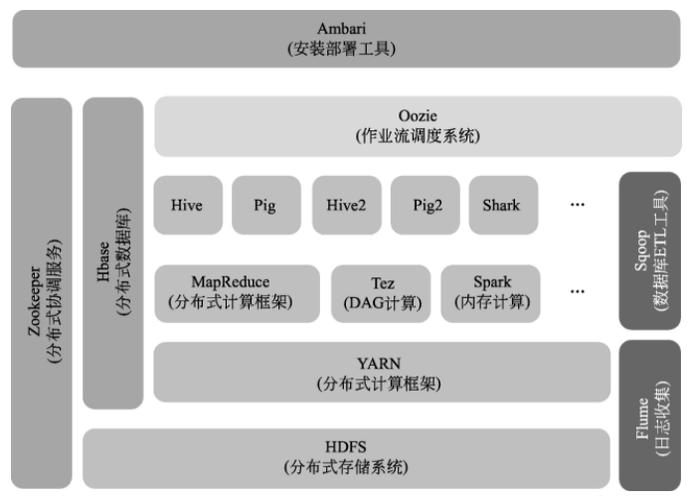

Hadoop是由Apache软件基金会开发的一个开源分布式计算框架,主要用于处理海量数据。它采用了分布式文件系统(HDFS)和分布式计算模型(MapReduce)两大核心技术。Hadoop集群由多个节点组成,包括NameNode、DataNode、Secondary NameNode、ResourceManager和NodeManager等。

二、本地搭建Hadoop集群的步骤

1. 环境准备

确保您的计算机操作系统为Linux、Windows或macOS。本文以Linux为例,介绍本地搭建Hadoop集群的步骤。

(1)安装Java环境:Hadoop依赖于Java环境,因此首先需要安装Java。您可以从Oracle官网下载Java安装包,按照提示进行安装。

(2)配置Java环境变量:在Linux终端输入以下命令,将Java环境变量添加到系统环境变量中。

```

export JAVA_HOME=/usr/local/java/jdk1.8.0_231

export PATH=$PATH:$JAVA_HOME/bin

```

2. 下载Hadoop安装包

从Apache官网下载Hadoop安装包(版本可根据需要选择),解压到指定目录。

3. 配置Hadoop环境

(1)编辑`hadoop-env.sh`文件,配置Hadoop运行所需的Java环境变量。

```

export JAVA_HOME=/usr/local/java/jdk1.8.0_231

```

(2)编辑`core-site.xml`文件,配置Hadoop核心参数。

```xml

```

(3)编辑`hdfs-site.xml`文件,配置Hadoop分布式文件系统参数。

```xml

```

(4)编辑`mapred-site.xml`文件,配置MapReduce相关参数。

```xml

```

(5)编辑`yarn-site.xml`文件,配置YARN相关参数。

```xml

```

4. 格式化NameNode

在Linux终端执行以下命令,格式化NameNode。

```

hadoop namenode -format

```

5. 启动Hadoop集群

(1)启动HDFS。

```

start-dfs.sh

```

(2)启动YARN。

```

start-yarn.sh

```

(3)启动History Server。

```

mr-jobhistory-daemon.sh start historyserver

```

至此,您已完成本地搭建Hadoop集群,可以开始使用Hadoop进行大数据处理了。

本文为您介绍了如何在本地搭建Hadoop集群,通过配置Java环境、下载Hadoop安装包、配置Hadoop环境、格式化NameNode和启动Hadoop集群等步骤,使您轻松应对大数据挑战。在实际应用中,您可以根据需要调整Hadoop集群的配置,以满足不同的数据处理需求。