文章目录

[+]

通过这个协议,网站可以见告搜索引擎哪些页面可以抓取,哪些不可以,从而保护敏感信息和用户隐私不被陵犯。以下是一些详细解释:

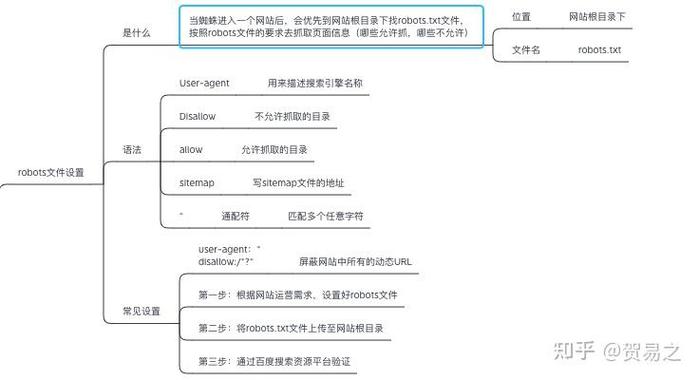

基本观点:robots协议是位于网站根目录下的robots.***文件,用来指示搜索引擎爬虫哪些页面可以访问,哪些页面禁止访问。这种协议供应了一个标准,使网站能够掌握其内容被搜索引擎收录的范围。这对付资源有限的网站尤其主要,由于搜索引擎蜘蛛的频繁访问可能会对其造成包袱。事情事理:当搜索引擎蜘蛛访问一个网站时,会先读取robots.***文件,然后按照该文件中的规则进行抓取。如果网站上没有robots.***文件,搜索引擎常日会默认许可抓取所有页面,包括敏感信息和个人数据。语法规则:在robots.***文件中,常日利用User-agent指定某个特定的搜索引擎机器人,用Disallow表示禁止访问的路径,而Allow则表示许可访问的路径。例如,若想禁止所有搜索引擎访问/private目录,可以这样写:User-agent: Disallow: /private。最佳实践:遵守Robots协议是网络爬虫开拓者应遵照的基本原则之一。这不仅有助于减少对做事器的压力,还能避免因不合规的爬取行为引起的法律风险。开拓者可以通过设置合理的爬取间隔、掌握并发连接数来减轻对目标网站的压力。总的来说,Robots协议不仅是网站与搜索引擎之间沟通的主要桥梁,也是保护网站内容不被恶意抓取的有效工具。网站管理员和开拓者应该合理利用这一协议,以确保网站的安全性和隐私保护水平。

保定网站培植,保定小程序开拓,网站设计

(图片来自网络侵删)