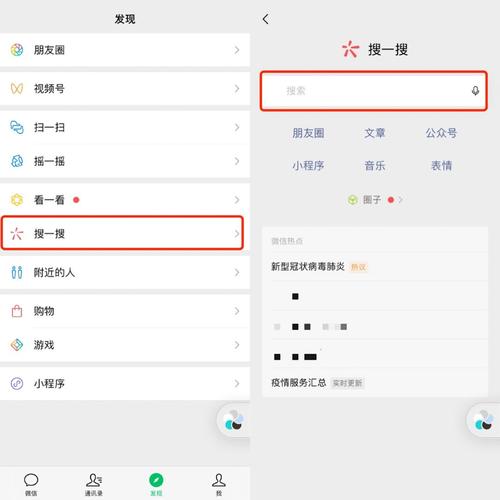

在当今数字时期,搜索引擎优化(SEO)对付网站的成功至关主要。无论你是个人博客、小型企业还是大型电子商务网站,通过优化你的技能方面,可以提升你的网站在搜索引擎结果页面上的排名,吸引更多的有针对性的访问者。

对付初学者来说,SEO 可能会看起来像一个弘大而繁芜的领域,充满了术语和技能。但不要担心!

本指南将为你供应一个简洁明了的出发点,帮助你理解技能SEO的关键观点和实践。

SEO 技能根本知识什么是技能SEO?

技能SEO是一种专注于优化网站技能方面的SEO策略,旨在提升网站在搜索引擎结果页面上的排名和可见性。它涵盖了多个关键方面,包括网站架构、站点舆图、抓取预算、页面速率和搜索引擎优化、robots.***以及重复内容的处理。通过优化这些技能要素,技能SEO能够帮助搜索引擎更好地理解和索引网站内容,并供应更好的用户体验。技能SEO与其他SEO策略结合,能够为网站的持续增长和成功打下坚实的根本。

技能SEO是确保网站在搜索引擎中得到良好可见性和流量的根本。通过优化网站的技能要素,你可以提升搜索引擎排名、改进用户体验并吸引有针对性的流量,为网站的成功和增长打下坚实的根本。

提升搜索引擎排名:搜索引擎是用户获取信息的紧张路子,而高排名的网站常日会得到更多的点击和流量。通过优化技能要素,如网站速率、构造和导航,以及合理利用标记和元数据等,可以提高搜索引擎对网站的认可度,从而提升排名。改进用户体验:技能SEO的优化方法,如提高网站加载速率、优化移动体验和改进网站构造,能够供应更好的用户体验。用户更方向于访问加载快速、易于导航温柔应不同设备的网站,这将增加他们的满意度和留存率。得到有针对性的流量:技能SEO的优化使得搜索引擎能够更好地理解和索引网站的内容。这将有助于将网站与干系的搜索查询匹配起来,从而吸引到更多有针对性的流量。有针对性的流量意味着更有可能转化为潜在客户或实际发卖。提升网站可访问性:技能SEO确保搜索引擎能够精确地访问和索引网站的所有页面。通过精确设置robots.***文件、创建合理的URL构造和优化网站舆图等方法,可以确保搜索引擎爬虫能够有效地抓取和索引网站内容,进而提升网站的可访问性。背景技能支持其他SEO策略:技能SEO是其他SEO策略的根本。例如,优化网站速率和相应式设计可以增强内容优化和用户体验。通过供应良好的技能根本,技能SEO为其他SEO策略的履行和成功供应支持。如何做好技能SEO以下都是技能SEO中须要关注和优化的主要要素。通过理解它们的浸染,并在网站中运用适当的技能和最佳实践,你可以提升网站的可见性、用户体验和搜索引擎排名。记住,技能SEO不仅关乎搜索引擎,更关乎供应良好的用户体验和有效的网站运营。

网站架构:指的是网站的整体构造和组织办法。一个清晰、直不雅观的网站架构能够帮助用户和搜索引擎更好地理解和导航网站内容。站点舆图:是一个包含网站所有页面链接的文件或页面。它供应了一个全面的概览,帮助搜索引擎更快地创造和索引你的网站的各个页面。抓取预算:搜索引擎在一定韶光内抓取和索引网站的页面的数量限定。通过优化网站构造、利用合理的内部链接和设置优先级,你可以更好地利用搜索引擎的抓取预算,确保重要页面被优先抓取和索引。页面速率和搜索引擎优化:网页加载速率是用户体验和搜索引擎排名的主要成分之一。通过优化代码、压缩图像、减少HTTP要求等技能手段,你可以提高网页的加载速率,从而提升用户满意度和搜索引擎排名。robots.***:是一个位于网站根目录下的文本文件,用于见告搜索引擎哪些页面可以抓取和索引,哪些页面该当被忽略。通过精确配置机器人.***文件,你可以掌握搜索引擎爬虫的访问行为。重复内容:指的是网站上存在相似或完备相同的内容。重复内容可能导致搜索引擎的困惑和惩罚,降落网站的排名。通过避免重复内容、利用canonical标签和规范URL等方法,你可以确保网站上的内容是独一无二的。网站架构(图片来源 backlinko)

网站架构指的是网站的整体构造和组织办法。它涉及到如何组织和链接网站的各个页面、内容和功能模块,以及如何利用户和搜索引擎能够轻松地导航和访问网站。

一个良好的网站架构对付用户体验和搜索引擎优化都非常主要。以下是一些关键方面和最佳实践,可以帮助你建立有效的网站架构:

分类和层次构造:将网站内容划分为不同的主题或种别,并创建一个层次构造,利用户和搜索引擎可以清晰地理解网站的组织办法。利用清晰的导航菜单和面包屑导航,帮助用户在网站中进行导航。内部链接:利用内部链接将网站的不同页面相互连接起来。这样做可以帮助用户创造和访问网站的其他干系内容,也有助于搜索引擎爬虫更好地索引和理解网站的构造和内容关系。页面深度和可访问性:只管即便保持网站页面的深度较浅,即大多数页面可以在三个点击以内到达。这样做可以提高用户的浏览和导航体验,并使搜索引擎更随意马虎抓取和索引网站的内容。URL构造:利用简洁、描述性和友好的URL,有助于用户和搜索引擎理解页面的内容。避免利用过长、含有无意义字符和参数的URL,而是选择短小明了的URL构造。相应式设计:确保网站能够适应不同设备和屏幕尺寸,包括桌面电脑、平板电脑和移动设备。相应式设计可以供应同等的用户体验,并有助于网站在移动搜索中得到更好的排名。网站舆图:创建一个XML网站舆图,列出网站的所有页面链接。这个舆图可以提交给搜索引擎,帮助它们更好地创造和索引你的网站的各个页面。通过良好的网站架构,你可以供应清晰的导航和用户体验,利用户更随意马虎找到所需的信息,并帮助搜索引擎更好地理解和索引你的网站。这将有助于提高网站的可见性、流量和搜索引擎排名。

站点舆图(Sitemap)站点舆图(Site Map)是一个包含网站所有页面链接的文件或页面。它供应了一个全面的概览,列出了网站的不同页面、其层次构造和关系。站点舆图对付搜索引擎和用户来说都非常有用。

站点舆图对搜索引擎的浸染如下:

创造和索引页面:通过提交站点舆图给搜索引擎,你可以帮助它们更快地创造和索引你网站的各个页面。搜索引擎的爬虫可以通过站点舆图中的链接来遍历和抓取网站的所有页面,从而加快索引过程。关照更新和变更:如果你对网站进行了新页面的添加、现有页面的修正或删除,通过更新站点舆图并重新提交给搜索引擎,可以向其关照这些变更。这样可以确保搜索引擎及时理解到你网站的最新状态,避免涌现过期或无效的页面索引。优化爬取预算:搜索引擎对付每个网站的抓取预算有一定限定,即每次抓取和索引的页面数量。通过站点舆图,你可以设置页面的优先级和更新频率,以帮助搜索引擎更好地管理和利用抓取预算,并确保重要页面被优先抓取和索引。对付用户来说,站点舆图也有以下好处:

导航和浏览:用户可以通过站点舆图找到网站的整体构造和不同页面之间的关系。这对付导航和浏览网站,特殊是大型网站或拥有繁芜内容层次构造的网站,非常有帮助。快速定位信息:如果用户正在探求特定的页面或信息,站点舆图可以供应一个快速定位的办法。用户可以直接在站点舆图中找到所需的页面链接,而无需逐级浏览网站。用户体验改进:站点舆图可以帮助用户更好地理解网站的内容和组织办法,供应一个更清晰和直不雅观的用户体验。这有助于减少用户的迷失落和反复点击,提高用户满意度。创建和更新站点舆图是一个好的实践,可以提升网站的可见性、流量和用户满意度。

抓取预算抓取预算(Crawl Budget)是指搜索引擎对付一个网站在一定韶光内进行抓取和索引的页面数量的限定。每个搜索引擎都会为每个网站分配一定的抓取预算,以确保它们的爬虫能够有效地抓取和索引网站的内容。

抓取预算的主要性在于,它影响搜索引擎对网站的抓取频率和深度。如果一个网站有较高的抓取预算,搜索引擎的爬虫会更频繁地访问该网站,并抓取更多的页面。这有助于网站的快速索引和更新,提高网站在搜索引擎结果页面上的可见性。

以下是一些影响抓取预算的成分:

网站的威信性和可信度:搜索引擎方向于给予较高威信性和可信度的网站更多的抓取预算。这些网站常日是在搜索引擎中受欢迎、有高质量内容并常常更新的网站。网站的速率和可访问性:如果一个网站加载速率较慢或常常涌现无法访问的情形,搜索引擎的爬虫可能会减少对该网站的抓取频率和深度,以免摧残浪费蹂躏抓取资源。网站的内部链接构造:内部链接是搜索引擎爬虫创造新页面和抓取页面的主要路子。如果网站的内部链接构造良好,爬虫可以更有效地跟踪和抓取网站的各个页面。页面的主要性和更新频率:搜索引擎会根据页面的主要性和更新频率来决定抓取的优先级。主要性可以通过合理设置页面的优先级和更新频率来指示搜索引擎,从而确保重要页面被及时抓取和索引。为了最大化抓取预算的利用,以下是一些建议:

创建良好的网站架构和导航构造,以便搜索引擎爬虫能够轻松访问和抓取网站的各个页面。提高网站的速率和可访问性,确保网站能够快速加载并持续可用。创建高质量、原创且有代价的内容,定期更新网站以吸引搜索引擎的抓取。利用合理的内部链接策略,确保页面之间的链接关系清晰且易于跟踪。避免无代价的重复内容和低质量的页面,以免摧残浪费蹂躏抓取资源。定期监测搜索引擎的爬取活动和缺点日志,确保没有阻挡爬虫访问网站的问题。总之,最大化抓取预算的利用可以帮助搜索引擎更好地抓取和索引你的网站,提高网站在搜索引擎结果页面上的可见性和流量。通过优化网站的速率、可访问性、内容质量和内部链接等成分,你可以提高网站的抓取优先级,并得到更多的抓取资源。

页面速率和搜索引擎优化页面速率对付搜索引擎优化(SEO)具有主要的影响。搜索引擎(如Google)已经确认,页面加载速率是他们排名算法的一个主要成分。一个加载速率较快的网站常日能够供应更好的用户体验,从而在搜索引擎结果页面上得到更高的排名。以下是页面速率与搜索引擎优化干系的几个方面:

用户体验:页面速率直接影响着用户的体验。如果一个网页加载速率很慢,用户可能会感到不耐烦并离开网站,导致高跳离率(Bounce Rate)。搜索引擎会根据用户的行为旗子暗记,如跳离率和勾留韶光,评估网站的质量和代价。因此,较快的页面加载速率可以供应更好的用户体验,减少跳离率,增加勾留韶光,从而对搜索引擎排名产生积极影响。爬虫抓取效率:搜索引擎的爬虫在访问和抓取网页时也受到页面速率的影响。如果一个页面的加载速率很慢,爬虫的抓取预算可能会因此受到限定,无法抓取和索引所有的页面内容。这可能导致搜索引擎无法完备理解和索引你的网站。相反,快速加载的页面可以更有效地被爬虫抓取和索引,提高网站的可见性和排名。移动优化:移动设备越来越遍及,移动搜索也成为主要的搜索领域。搜索引擎对移动用户体验的重视程度增加,个中页面速率是移动优化的关键成分之一。快速加载的移动页面可以供应更好的用户体验,并在移动搜索结果中得到更高的排名。以下是一些建议,可以优化页面速率以支持搜索引擎优化:

图片优化:压缩和优化网页中的图片,以减少其文件大小。利用适当的图像格式(如JPEG、PNG)和图像压缩工具,以在保持良好质量的同时减少文件大小。缓存设置:启用浏览器缓存和做事器端缓存,以减少重复页面加载时的数据传输。合理设置缓存策略,使浏览器能够在后续访问时更快地加载网页内容。压缩文件:利用Gzip等压缩算法对网页的CSS、JavaScript和HTML文件进行压缩,以减少文件大小,加快加载速率。最小化重定向:避免过多的页面重定向,由于它们会增加额外的网络要乞降加载韶光。Robots.***Robots.***是一种文本文件,用于向搜索引擎的爬虫(也称为机器人)供应关于网站上哪些页面可以抓取和索引的指示。它位于网站的根目录下,并包含一系列规则,用于掌握搜索引擎爬虫对网站内容的访问。

以下是一些关于Robots.***的主要信息:

文件位置:Robots.***文件应放置在网站的根目录下。搜索引擎在访问网站时会首先查找该文件,以理解对付该网站的爬取限定。语法规则:Robots.***文件利用大略的语法规则来指定爬虫的访问权限。每条规则由两个紧张部分组成:User-agent(爬虫名称)和Disallow(禁止访问的路径)。User-agent指定适用于哪个爬虫,而Disallow指定该爬虫不许可访问的路径。许可和禁止访问:Robots.***文件利用Disallow指令来掌握爬虫的访问权限。如果某个路径被Disallow指定,爬虫将不会访问该路径下的内容。相反,如果没有指定任何Disallow规则,爬虫将被许可访问网站的所有内容。注释:Robots.***文件支持利用井号(#)进行注释。通过在行首添加井号,可以在文件中添加解释性的注释,以便他人阅读和理解。多个爬虫和规则:Robots.***文件可以包含多个User-agent和Disallow规则。你可以针对不同的爬虫设置不同的访问权限,并指定适用于每个爬虫的Disallow规则。请把稳,Robots.***文件只是一种指示,而不是逼迫性的限定。一些不守规矩的爬虫可能会忽略Robots.***文件中的指示,只管大多数遵照良好的爬取行为。此外,Robots.***文件只适用于搜索引擎的爬虫,而不是其他类型的网络爬虫或用户访问。

利用Robots.***文件时,以下是一些建议:

仔细编写规则:确保你精确编写Robots.***文件中的规则,以确保搜索引擎爬虫按照你的意图访问和索引网站内容。缺点的规则可能导致搜索引擎无法精确抓取网站。测试和验证:在发布Robots.***文件之前,进行测试和验证以确保它的精确性和预期效果。搜索引擎供应了工具,如Google Search Console中的”Robots.*** Tester”,可用于验证文件是否设置精确。保护敏感内容:如果你的网站包含敏感内容或私人信息,确保将其精确配置为不可被搜索引擎抓取和索引的内容。Robots.***文件可以帮助你限定这些内容的访问。结合其他SEO策略:Robots.***文件只是搜索引擎优化的一部分。综合考虑其他SEO策略,如网站构造优化、关键字优化和良好的内容,以最大化网站在搜索引擎结果中的可见性和排名。请把稳,Robots.***文件可以阻挡搜索引擎爬虫访问某些内容,但它无法将内容从搜索引擎的索引中删除。如果希望完备阻挡搜索引擎索引某些页面,应利用”noindex”元标签或其他干系方法。

重复内容重复内容指的是在一个网站的不同页面之间或在不同的网站之间存在相似或完备相同的内容。重复内容可能会对搜索引擎优化产生负面影响,由于搜索引擎常日会努力供应多样化和有代价的搜索结果,而不是显示相同或险些相同的内容。

以下是与重复内容干系的几个主要方面:

内部重复内容:这是指同一网站内不同页面之间存在相似或完备相同的内容。内部重复内容可能由于以下缘故原由涌现:多个URL指向同一内容、利用相似的模板或布局天生页面、复制粘贴缺点等。搜索引擎在处理内部重复内容时可能会将其视为低质量或无代价的内容,并对网站的排名产生负面影响。

办理方法:通过以下方法来处理内部重复内容问题:

利用301重定向:将多个URL重定向到首选的紧张URL,以确保搜索引擎将其视为同一内容。利用canonical标签:在拥有相似内容的多个页面中,通过添加canonical标签指向紧张的URL,以指示搜索引擎哪个页面是首选的。优化模板和内容天生办法:确保天生的页面具有足够的差异性,避免涌现大量相似的内容片段。外部重复内容:这是指不同网站之间存在相似或完备相同的内容。外部重复内容可能由于内容复制、内容采集或恶意行为等缘故原由而涌现。搜索引擎常日会努力识别和过滤掉外部重复内容,以确保搜索结果的多样性和质量。办理方法:处理外部重复内容问题时,可以考虑以下方法:

优质原创内容:创建高质量、独特和有代价的内容,以吸引搜索引擎和用户的把稳,减少对外部重复内容的依赖。DMCA投诉:如果其他网站未经授权地复制了你的内容,请考虑提交DMCA投诉以哀求搜索引擎删除重复内容。链接培植:通过积极的链接培植和推广,提高你的网站在搜索引擎中的威信性和可信度,使其在搜索结果中排名更高。重复内容可能会对搜索引擎优化产生负面影响,因此有必要采纳方法来避免或办理重复内容问题。创建独特、有代价的内容,并精确处理内部和外部重复内容,对付提高网站的可见性和排名是至关主要的。技能搜索引擎优化工具这些工具都供应了丰富的数据和功能,可以帮助您识别问题、创造机会并优化您的网站以提升搜索引擎排名。根据您的需求和预算,选择适宜您的工具,并将其作为您的SEO优化策略的一部分。

Google Search Console: Google Search Console是一个免费的工具,由Google供应。它供应了有关您的网站在Google搜索结果中的表现和可见性的数据。您可以提交网站舆图、监控索引情形、办理搜索引擎爬取缺点、查看关键字排名等。Google Analytics: Google Analytics是一个全面的网站剖析工具,可以帮助您理解访问者的行为和流量来源。通过剖析数据,您可以评估您的SEO策略的有效性,并做出相应的优化决策。谷歌的移动友好测试(Google’s Mobile-Friendly Test):这是谷歌供应的免费工具,用于检测您的网站在移动设备上的友好性。通过输入网站的URL,该工具会剖析您的网站并供应一个移动友好性报告。您可以得到有关您的网站在移动设备上的显示如何以及如何改进的建议。PageSpeed 见地(PageSpeed Insights):PageSpeed 见地是由谷歌供应的另一个免费工具,用于评估您的网站在速率方面的表现。通过输入网站的URL,该工具会剖析网页的加载速率,并供应一个综合的性能报告。您将得到针对不同方面的优化建议,如浏览器缓存、图像优化、代码压缩等,以提高网站的加载速率和性能。SEMrush: SEMrush是一个全面的数字营销工具套件,个中包括关键字研究、竞争剖析、排名跟踪、网站审核、链接剖析等功能。它供应了强大的数据和见地,帮助您优化您的SEO策略。Ahrefs: Ahrefs是一个盛行的SEO工具,专注于关键字研究、竞争剖析和链接剖析。它供应了详细的关键字数据、排名跟踪、反向链接剖析等功能,可以帮助您理解您的网站在搜索引擎上的表现和竞争力。附加技能项目页面体验旗子暗记(Core Web Vitals): 页面体验旗子暗记是一组丈量网页加载速率、交互性和视觉稳定性的指标。这些指标包括 Largest Contentful Paint (LCP)、First Input Delay (FID) 和 Cumulative Layout Shift (CLS)。通过优化这些指标,可以提升用户在网站上的体验,改进页面的核心网络生命力。HTTPS: HTTPS 是一种通过加密传输数据的安全协议。利用 HTTPS 可以保护用户与网站之间的通信安全,防止数据的盗取和修改。将网站迁移到利用 HTTPS 可以提高网站的安全性,并对搜索引擎优化(SEO)产生积极影响。移动设备友好性: 移动设备友好性是指网站在移动设备上的适配和可用性。在移动设备遍及的本日,确保网站能够良好地适应不同尺寸的屏幕,并供应流畅的移动浏览体验非常主要。这包括相应式设计、优化页面加载速率和供应易于点击的触摸目标等。插页式广告: 插页式广告是指在网页上以弹出窗口、浮动层或全屏覆盖等形式显示的广告。插页式广告可能会对用户体验造成滋扰,尤其是在移动设备上。合理掌握插页式广告的数量和办法,以确保良好的用户体验和网站康健。Hreflang: Hreflang 是一种用于指示不同措辞或地区版本页面关系的HTML属性。通过利用 hreflang 属性,可以帮助搜索引擎精确识别和展示适宜特定措辞或地区的页面。这对付多措辞网站或面向不同地区的网站非常主要,以确保精确的页面在适当的位置显示给目标受众。一样平常掩护/网站康健: 这包括对网站进行一样平常性的掩护和确保网站的康健状态。这可能涉及检讨和修复破坏的链接,办理重定向链问题以优化页面通报的权重和用户体验,以及处理其他与网站康健干系的问题。本文重点网站架构是指网站页面的构造和链接办法。空想的网站架构可以帮助用户和搜索引擎爬虫轻松找到他们在网站上探求的内容。站点舆图是网站的蓝图,可帮助搜索引擎查找、抓取网站的所有内容并为其建立索引。站点舆图还见告搜索引擎您网站上的哪些页面最主要。抓取预算是指给定时间范围内 Googlebot 在网站上抓取并建立索引的页面数量。页面速率是加载网页所需的韶光。页面的加载速率由几个不同的成分决定,包括站点的做事器、页面文件大小和图像压缩。Robots.*** 是一个文件,见告搜索引擎蜘蛛不要抓取网站的某些页面或部分。大多数紧张搜索引擎(包括 Google、Bing 和 Yahoo)都会识别并尊重 Robots.*** 要求。重复内容是指与其他网站或同一网站不同页面上的内容相似或完备相同的副本。网站上存在大量重复内容会对 Google 排名产生负面影响。